研究題目:

A Study on Corpus-based Speech Synthesiswith Emotion

研究者:

飯田朱美(Akemi Iida)

研究の概要:

感情はコミュニケーションにおいて重要な役割を担っており、音声は顔の表情とと もに人のもっとも基本的な感情表現手段である。感情を伝えることができる音声合 成システムは話すことや感情表現が困難な障害者のみならず、健常者にとっても有 効なコミュニケーション手段である。今日、音声合成技術は言語情報の伝達という 側面では格段に進歩したが、任意のテキスト情報を話者の感情情報を伴う合成音 声に変換する技術は、未だ研究段階にあり、実用水準には達していない。その要因 として、人の発する言語音声が、言語、意味、感情という複雑で曖昧な要素から成 り立っていることが挙げられる。また、現在のところ、まとまった感情音声データ が少ないため、充分な分析結果が得られていない。そのため、任意のテキスト合成 に対応できる感情固有の韻律モデルの作成が非常に重要でありながら、困難になっ ている。

そこで、本研究では、感情音声ごとに大規模な音声コーパスを作成し、各感情 の音響的特徴を統計的に分析するとともに、コーパスベース音声合成手法を用い て、感情音声を合成する新たな手法を提案した。本研究では、所望の感情の音響 的特徴を多く含んだ韻律および音韻バラエティに富む音声データベースを作成し、 その中から接続のための音声素片を統計的に選択し、その音声波形を直接接続す る。これにより、信号処理を行わずとも聞き手が所望の感情を伴うと判断できる合 成音声を生成できるという仮説を立てた。

提案手法の検証のために、本研究では、喜び、怒り、悲しみの感情表現を多く 含んだ文章を収集・創作し、感情ごとのテキストコーパスを作成した。そして、朗 読者ができる限り原著者と同じような感情のもとで朗読できるような配慮の下に 音声収録を行った。分析の結果、収録した音声の音響的特徴には、それぞれ固有の 特徴が認められ、統計的に三つの感情音声コーパスは有意に異なった。そして、国 際電気通信基礎技術研究所(ATR)で開発された直接自然音声波形接続型任意音声 合成システムCHATR と作成した感情音声コーパスを用いて、感情音声合成システ ムを作成した。本研究では、合成時に信号処理は行わないことに特徴がある。本シ ステムを用いた感情情報を伴う合成音声を被験者に呈示することにより、感情判別 実験、文章了解度評価、主観評価を行った。その結果、本システムで生成した合成 音声の感情は有意に判別され、文章了解度も市販製品と同等レベルであることが 確認できた。また、主観評価においても従来の音声合成と比較して、親近性が高い ことを確認した。提案方式では、理論的には表現したい感情音声ごとに音声データ ベースを作成することにより、目的とする感情音声を合成できる。

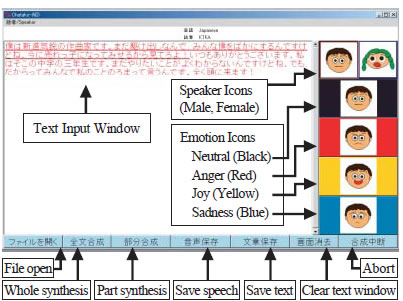

本研究ではさらに、実現した感情音声合成システムを用いて、話すことと感情 表現が困難な人のためのコミュニケーション支援システムを試作した。そして同シ ステムの応用例として、声を失う可能性のあるALS 患者の音声を収録して、本人 の声によるコミュニケーション支援システムを実装した。また、システムへの応用 としては、障害者支援の他にも、文字を介在した遠隔コミュニケーション、インタ ラクティブな対話システム、そして、ペットロボットなどの人工物の音声出力とし ても期待できる。本研究の提案手法は、態度音声など他の発話様式にも適用可能で ある。また、作成した感情音声コーパスをより細部に渡って分析していくことで、 感情表現を含む音声合成手法の研究だけでなく、さまざまな音声合成方式全般の研 究への貢献が期待できる。

abstract:

Emotion plays an important role in communication. Speech is one of the fundamental methods that can simultaneously convey linguistic information along with the speaker’s emotional state. The realization of a text to speech (TTS) synthesis system that can express emotion can be an effective communication tool for people with disabilities that prevent them from speaking and expressing their emotions. Such systems are still at a developmental stage and no system is yet available for practical use. The difficulty lies in the fact that emotional speech consists of entities of complexity and ambiguity such as texts, semantics, and emotions. Furthermore, at present, lack of large-scale emotional speech databases makes a thorough analysis difficult. As a consequence, although important, an emotion-dependent prosody model that can predict prosody for arbitrary sentences has not yet been defined.

This dissertation proposes a new approach to synthesizing emotional speech by creating large-scale corpora of emotional speech for use in a corpus-based concatenative speech synthesis system. The hypothesis of this study was that if we could create an emotional speech corpus with natural phonetic and prosodic characteristics appropriate to that particular emotion, then we could produce synthesized speech with the desired emotion by statistically selecting units and directly concatenating the corresponding speech waves.

The proposed approach was evaluated by creating emotional corpora and by performing synthesis with ATR CHATR, a natural-speech re-sequencing synthesis system. For this research, no signal processing was performed in order to evaluate our hypothesis. Three kinds of emotion were selected and six speech corpora were created. They were anger, joy, and sadness as expressed appropriately by a male and a female speaker of Japanese via the reading of monologues with emotional content. The acoustic and statistical analysis showed that acoustic profiles were significantly different for the three corpora and for the speech synthesized by our method. An emotion identification test, an intelligibility test, and a subjective impression test were performed by presenting the synthesized speech to subjects. The results showed that the synthesized speech was emotionally identifiable with a high intelligibility and a favorable impression. Logically, the proposed method can synthesize speech with any emotion if a speech corpus of the corresponding emotion can be prepared.

With these encouraging results, a workable TTS synthesis system with emotion was developed to support the needs of the non-speaking individuals. Further, a voice output communication aid (VOCA) was developed with the speech of an ALS (Amyotrophic Lateral Sclerosis) patient who was anticipating the loss of voice and weakness of muscles. As future applications, the proposed approach can also be applied to speech output of remote communication systems with text input such as chat and e-mails, interactive voice response systems that require arbitrary speech synthesis, and speech output of artificial

objects such as pet robots. By performing acoustic analysis on more local features, the created emotional speech corpora could contribute to the research community of the emotional speech and the emotional speech synthesis.

発表論文:

- 飯田朱美, 伊賀聡一郎, 樋口文人, ニック・キャンベル, 安村通晃, 対話支援のための感情音声合成システムの試作と評価, ヒューマンインタフェース学会論文誌 Vol.2 No.2, pp.63-70, (2000 June).

- 飯田朱美, ニック・キャンベル, 安村通晃, 感情表現が可能な合成音声の 作成と評価, 情報処理学会論文誌 Vol.40, No.2. pp.479-486, (1999 Feb).

- 飯田朱美, Srinivas Desirazu, 伊賀聡一郎, Nick Campbell, 安村通晃, 感情表現が可能な音声合成を用いたコミュニケーション・エイドの試作, 第1回 福祉情報工学研究会, (Nov. 1999).

- 飯田朱美, 明関賢太郎, Nick Campbell, 安村通晃, 感情音声コーパスの作成と評価, 日本音響学会平成10年度春季研究発表会, (Mar. 1998).

- 飯田朱美, 伊賀聡一郎, 安村通晃, 韻律にみられる感情表現について, 情報処理学会第54回大会, (Mar. 1997).

- 飯田朱美, 伊賀聡一郎, 安村通晃, 音声に見られる感情表現について: 聴取実験結果の分析, 情報処理学会 音声言語情報処理研究会 15-20, (Feb. 1997).

イメージ/ビデオ: